Entre os riscos citados está a grande “pegada de carbono” ao desenvolver esse tipo de tecnologia de IA. Segundo algumas estimativas, o treinamento de um modelo de IA gera tantas emissões de carbono quanto o necessário para construir e dirigir cinco carros ao longo de suas vidas úteis. Com a IA se tornando uma ferramenta computacional cada vez mais utilizada em nossos meios tecnológicos, é necessário nos perguntarmos: por que os modelos de IA se tornaram tão famintos por energia? Como eles diferem da computação de centros de dados tradicionais?

O treinamento de IAs atual é ineficiente

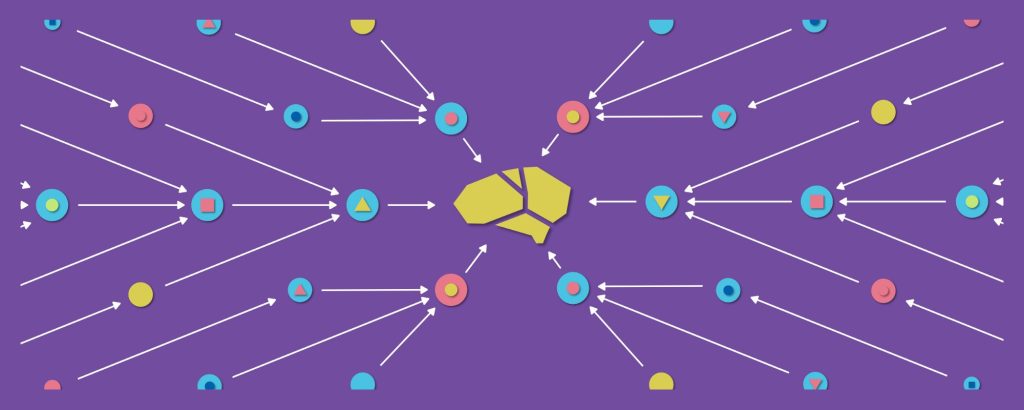

Os trabalhos tradicionais de processamento de dados realizados em centros de dados (mais conhecidos como data centers) incluem streaming de vídeo, e-mail e mídia social. A IA é mais intensiva em termos de computação porque precisa ler muitos dados até aprender a entendê-los, ou seja, ser treinada. Esse treinamento é ineficiente em comparação ao modo como as pessoas realmente aprendem. A IA moderna usa redes neurais artificiais, ou seja, cálculos matemáticos que simulam o comportamento dos neurônios do cérebro humano. A força de conexão de cada neurônio ao seu vizinho é um parâmetro da rede denominado peso. Dessa forma, para aprender a entender a linguagem, a rede começa com pesos aleatórios e os ajusta até que a saída concorde com a resposta correta. A imagem exemplifica o funcionamento de uma rede neural artificial simples. A rede recebe duas entradas: a imagem de um cachorro e de um gato que serão as entradas (“input”). O modelo sabe, previamente, que a resposta esperada é que a imagem selecionada seja a do cachorro. Assim sendo, cada seta que sai de uma entrada possui um peso de probabilidade diferente, que então é utilizado em combinação com a entrada para alimentar um dos neurônios da primeira camada (“hidden”). Cada neurônio então tem uma função matemática de custo definida que é calculada nos neurônios de saída (“output”). O neurônio que apresentar a maior probabilidade será a saída selecionada. Uma forma comum de treinar uma rede de idiomas, por exemplo, é alimentando-a com muitos textos de sites como Wikipedia e veículos de notícias com algumas das palavras ocultas e pedindo-lhe que adivinhe essas palavras. Um exemplo é “meu gato é bonito”, com a palavra “bonito” ocultada. Inicialmente, o modelo irá errar todas as “adivinhações” da palavra, mas, após muitas rodadas de ajuste, os pesos de conexão começam a mudar e a pegar padrões nos dados. Dessa forma, a rede eventualmente se torna precisa. É uma prática elegante da técnica de tentativa e erro. Para se ter uma ideia do tamanho dos datasets (conjunto de dados de treinamento) utilizados por IAs, um modelo recente desenvolvido pelo Google e denominado Bidirectional Encoder Representations from Transformers (BERT, “Representações de codificador bidirecional de transformadores”, uma homenagem ao personagem homônimo do programa Os Muppets) utilizou 3,3 bilhões de palavras de livros em inglês e artigos da Wikipedia. Além disso, durante o treinamento, o BERT leu este conjunto de dados não apenas uma vez, mas 40 vezes. Infelizmente, a execução de várias rodadas de treinamento é um passo essencial no processo de aprendizagem de uma IA, pois, como diz o ditado, “a prática leva à perfeição“. No caso da IA, quanto mais rodadas forem executadas, mais a IA se tornará precisa. No entanto, quando comparamos esse método a uma forma de aprendizagem utilizada para seres humanos, uma criança que está aprendendo a falar pode ouvir 45 milhões de palavras até os cinco anos, 3 mil vezes menos do que o BERT com sua metodologia de treinamento.

Em busca da estrutura neural certa

Justamente pelo processo de treinamento ocorrer em várias rodadas durante o desenvolvimento dessas IAs, os modelos de linguagem se tornam muito caros de construir. Isso ocorre justamente porque os pesquisadores querem encontrar a melhor estrutura para a rede, ou seja, quantos neurônios, quantas conexões entre os neurônios, a velocidade com que os parâmetros devem mudar durante o aprendizado e assim por diante. Quanto maior for o número de combinações diferentes que forem experimentadas durante o treinamento da IA, maiores serão as chances de atingir um alto grau de precisão. É um processo muito diferente daquele que ocorre com cérebros humanos, por exemplo, uma vez que nossas mentes não precisam encontrar uma estrutura ótima para compreender o mundo à nossa volta, pois os séculos de evolução já nos presentearam com uma estrutura pré-construída. À medida que empresas e acadêmicos competem no espaço de IA, há pressão para melhorar o “estado da arte” – termo que se refere ao maior patamar de conhecimento em uma área específica obtida até o momento atual. Até mesmo alcançar uma melhoria de 1% na precisão em tarefas difíceis como tradução automática é considerado uma conquista significativa e leva a boa publicidade e produtos melhores. No entanto, para obter essa pequena melhora, um pesquisador precisa treinar o modelo, milhares de vezes, cada vez com uma estrutura diferente, até que a melhor seja encontrada. Pesquisadores da Universidade de Massachusetts Amherst estimaram o custo de energia do desenvolvimento de modelos de IA para processamento de linguagem medindo o consumo de energia de hardware comum usado durante o treinamento. Eles descobriram que o treinamento do BERT, por exemplo, já teve custo de energia similar a um passageiro que fazia uma viagem de ida e volta entre Nova York e São Francisco. Porém, ao pesquisar usando estruturas diferentes – isto é, treinando o algoritmo várias vezes com o mesmo conjunto de datasets, mas com números ligeiramente diferentes de neurônios, conexões e outros parâmetros – o custo tornou-se o equivalente a 315 passageiros, ou um jato 747 inteiro!

IAs maiores e mais quentes

Outro grande problema dos modelos atuais de IA é que eles são muito maiores do que precisam ser e, pior, crescem a cada ano. Um modelo de linguagem mais recente semelhante ao BERT, denominado GPT-2, tem 1,5 bilhão de pesos ou parâmetros em sua rede. Por outro lado, o GPT-3, que possui alto grau de precisão, tem 175 bilhões de pesos! É natural que redes maiores levem a uma melhor precisão. Uma boa analogia para compreender porque toda a estrutura de um modelo de IA não é ativamente utilizada na predição de resultados é o que acontece no próprio cérebro humano, uma vez que nem todas as partes do cérebro são utilizadas para compreender um texto, por exemplo. A diferença está em que o cérebro biológico é muito mais eficiente em termos de energia do que os computadores. É preciso considerar que os modelos de IA são treinados em hardware especializado, como em grandes unidades de processamento gráfico, que consomem mais energia do que as CPUs tradicionais. Com as placas gráficas se tornando cada vez mais potentes e poderosas quando comparadas aos processadores normalmente utilizados nos computadores, faz sentido que algoritmos tão custosos sejam executados em componentes apropriados para suportar toda a demanda de cálculos, processamento e gasto de energia. Se você possui um PC ou laptop para jogos, provavelmente ele vem equipado com uma placa gráfica NVIDIA (na maioria dos casos) com tecnologia RTX. E não são apenas os pesquisadores e especialistas em informática que podem tirar vantagem do poder de processamento dessas placas gráficas para treinar seus modelos de IA, mas games que utilizam a tecnologia DLSS também aproveitam a capacidade computacional desses componentes. Mesmo assim, o problema do alto consumo de energia persiste, pois um PC ou laptop com esse tipo de placa gráfica gera muito mais calor que máquinas normais quando está utilizando a placa de vídeo para executar modelos de IA. Tudo isso significa que o desenvolvimento de modelos avançados de IA soma um grande custo de energia e, consequentemente, produz um alto impacto ambiental na geração dessa energia. A menos que mudemos para fontes de energia 100% renováveis, o progresso da IA pode estar em desacordo com as metas de redução das emissões de gases do efeito estufa e desaceleração das mudanças climáticas. Além disso, o custo do desenvolvimento de modelos de IA também está se tornando tão alto que apenas alguns laboratórios selecionados podem pagar por isso. Isso acaba gerando um monopólio daqueles que detém o conhecimento sobre o estado da arte de IAs e, também, a definição da forma como esses modelos serão desenvolvidos daqui à frente.

Construindo modelos de IA que fazem mais com menos

Mas, afinal, o que esse aumento exponencial nos custos energéticos dos modelos de IA significa para o futuro da pesquisa nessa área? Apesar de os indícios apontarem que os modelos só tendem a ficar maiores e mais custosos computacionalmente, ainda é possível imaginar uma perspectiva mais otimista para esse cenário. O custo do treinamento de modelos de IA pode diminuir à medida que métodos de treinamento mais eficientes são inventados. Da mesma forma, embora se previsse que o uso de energia de data centers explodisse nos últimos anos, isso não aconteceu devido a melhorias na eficiência desses centros gigantescos de armazenamento de dados, principalmente nos quesitos de aprimoramento de hardware e práticas de refrigeração mais eficientes. Também há uma compensação entre o custo de treinar os modelos de IA e o custo de usá-los, portanto, gastar mais energia na hora do treinamento para criar um modelo menor pode, na verdade, torná-los mais baratos. Afinal de contas, um modelo será usado muitas vezes durante sua vida útil, resultando em uma grande economia de energia. Além de aumentar sua eficiência e grau de precisão, o maior desafio da pesquisa em modelos de IA atualmente é buscar maneiras de torná-los menores, compartilhando pesos ou usando os mesmos pesos em várias partes da rede. Esse tipo de abordagem para a estrutura de rede neural chama-se redes de metamorfos, porque um pequeno conjunto de pesos pode ser reconfigurado em uma rede maior de qualquer formato ou estrutura. Pensando dessa forma, a comunidade de IA deve investir mais no desenvolvimento de esquemas de treinamento com eficiência energética. Caso contrário, corremos o risco de a IA ser dominada por um grupo seleto de empresas ou centros de pesquisas que irão estabelecer o futuro da IA, incluindo quais tipos de modelos serão desenvolvidos, quais tipos de dados serão usados e como o treinamento será realizado. No fim, teremos uma inteligência mais “empresarial” do que “artificial”. Fonte: ARS Techina